Введение: Ненужные страницы в индексе — это тихий слив бюджета и позиций

Откройте любой проект в Google Search Console, который не проходил регулярный техаудит. В 9 из 10 случаев в разделе «Индексирование» → «Страницы» вы найдете сотни, а иногда и тысячи исключённых URL. Большинство — это 404, страницы с редиректами или заблокированные ресурсы.

Вы скажете: «Это же исключённые страницы, они не в индексе, всё в порядке». А вот и нет. Сам факт их присутствия в этом отчёте — лишь верхушка айсберга. Реальная проблема глубже: поисковые системы продолжают обнаруживать и тратить ресурсы на эти URL, отвлекаясь от актуального контента.

С моей практики, на среднестатистическом сайте 10-20% краулингового бюджета Google и Яндекс уходит на обход технического мусора: битых ссылок после редизайна, дублей из-за неверных канонических тегов, служебных параметров сессий. Это не гипотеза — это цифры из лог-файлов, которые мы анализируем.

В чём конкретный ущерб? Он трёхсоставной и системный:

- Краулинговый бюджет. Робот, который проверяет `site.ru/cart?session_id=123`, не индексирует ваш новый раздел с высокочастотными запросами. На свежий контент просто не хватает «внимания».

- Поведенческие метрики. Пользователь, попавший из поиска на 404, — это гарантированный отказ. Массовые отказы с ключевых страниц — прямой сигнал алгоритмам о низком качестве ресурса.

- Структурная релевантность. Когда в индексе тысячи нерелевантных или дублирующих страниц, «сила» сайта (условный PageRank, внутренний вес) распределяется хаотично. Это размывает значимость действительно важных разделов.

Это не «возможная угроза». Это регулярно наблюдаемая закономерность. После грамотной чистки и настройки редиректов мы часто фиксируем рост индексации ключевых страниц и улучшение ранжирования по коммерческим запросам — просто потому, что робот наконец увидел сайт таким, каким он должен быть.

Если вы не управляете этим процессом — вы управляете лишь частью своего сайта. Остальным заправляет хаос.

Глава 1: Пять корней проблемы: почему в индексе живёт то, чего не должно быть

Казалось бы, удалил страницу — и она исчезла. В реальности, URL обладает поразительной живучестью. Он застревает в памяти поисковиков, как заноза. Основных причин пять, и мы разберём каждую не на уровне теории, а как это выглядит в реальных проектах.

1. Удалённый или перемещённый контент: «Зомби-ссылки»

Вы удалили старый акционный лендинг или перенесли раздел блога из `/blog/` в `/articles/`. Вы сделали это в админке CMS, но что произошло дальше?

А почему страница всё ещё в индексе? Потому что система ссылок о ней помнит. Внутренние перелинковки с других страниц сайта, внешние ссылки с форумов и каталогов, упоминания в соцсетях — всё это продолжает вести на старый адрес. Робот, идя по этим следам, натыкается на 404 и фиксирует ошибку, но сам URL из его базы не стирается.

Личный инсайт: Самые живучие «зомби» — это страницы, на которые когда-то были настроены внешние рекламные кампании (таргет, контекст). Ссылка из объявления умерла год назад, а в индексе и логах — живёт. Регулярно проверяйте входящие ссылки в Яндекс.Вебмастере и GSC на предмет таких «мёртвых якорей».

2. Технические дубликаты: болезнь роста большинства CMS

Это не просто «страница доступна с www и без». Это системная проблема плохой конфигурации. Современные CMS по умолчанию часто отдают один и тот же контент по 5-10 разным адресам. Самые частые сценарии в моей практике:

- Сессионные идентификаторы и параметры отслеживания (`?sessionid=ABC`, `?utm_source=facebook`). Без должной настройки каждый такой URL — отдельная страница для робота.

- Сортировки и фильтры в каталогах (`/catalog/?sort=price&order=asc`). Если их не закрыть, поисковик уйдёт в бесконечный тоннель мусорных комбинаций.

- Протоколы и зеркала (http/https, с `www` и без). Пока не прописан главный зеркальный домен и не настроены 301-редиректы, у вас не один сайт, а четыре.

Моё мнение: Борьба с дублями — это первый и обязательный этап любого технического аудита. Пока она не решена, все дальнейшие усилия по SEO будут давать усечённый результат.

3. Служебные и системные страницы: слепая зона разработчиков

Разработчик создаёт функционал «поиска по сайту» или «корзины». Его задача — чтобы он работал для пользователя. Задача SEO — чтобы эти страницы не попадали в поиск. Это классический конфликт целей.

Почему они появляются в индексе? Потому что на них могут вести:

- Публичные ссылки (например, кнопка «Корзина» в хедере).

- Неаккуратные скрипты или карты сайта, сгенерированные по умолчанию.

- Робот, который просто перебирает всё подряд.

Важный нюанс: Страницы с результатами внутреннего поиска (`/search/?q=query`) — это чистейший мусор для индекса. Они не только дублируют основной контент, но и могут показывать его в урезанном или искажённом виде.

4. Ошибки в sitemap.xml: благие намерения, ведущие в тупик

sitemap — это не «раз и навсегда». Это живой файл. Самые частые ошибки:

- Плагин для генерации карты сайта продолжает туда добавлять URL, которые вы уже закрыли `noindex`.

- В карте остались ссылки на товары или статьи, удалённые полгода назад.

- В sitemap попали служебные URL (например, те же страницы фильтров).

Что происходит? Вы сами, через sitemap, приглашаете робота на мёртвые или нерекомендуемые страницы. Он доверяет вам и идёт. Это худший сценарий растраты краулингового бюджета.

5. Следы взлома или спам-страницы: чёрная метка

Это уже не техническая ошибка, а угроза. Взломщики часто создают на сайтах тысячи страниц со спамным контентом (продажа фармы, казино, порно). Они маскируют их от владельца (noindex, nofollow), но целенаправленно прогоняют через них краулеры для наращивания ссылочной массы или других манипуляций.

Как понять, что это оно? Массовое появление в индексе или логах странных URL с неестественными словами, на непонятных языках, часто в поддиректориях вроде `/kkaz/` или `/pharma/`. Это сигнал тревоги, требующий не просто чистки, а срочного аудита безопасности.

Глава 2: Диагностика: снимаем слепки. Где искать нежелательные страницы?

Здесь многие допускают главную ошибку: ограничиваются лишь одним инструментом. Как врач ставит диагноз по совокупности анализов, так и мы должны собрать данные из трёх независимых источников: вебмастеров, краулеров и логов сервера. Только их пересечение даст полную картину.

1. Вебмастеры (Google Search Console & Яндекс.Вебмастер): смотрим глазами поисковика

Это не просто «проверить отчет». Нужно понимать логику данных.

- Google Search Console: Идем строго по пути «Индексирование» → «Страницы».

- «Исключено» — здесь лежит основной массив того, что Google *обнаружил, но не проиндексировал*. Нас интересуют две вкладки: «Не найдено (404)» и «Заблокировано robots.txt». Первое — прямые битые ссылки. Второе — потенциальная угроза: страницы, которые вы, возможно, зря скрыли.

- Простой лайфхак: Экспортируйте список URL из отчета «Не найдено» и проверьте их через скрипт или плагин на предмет внутренних ссылок. Часто вы найдёте у себя в меню или футере ссылки на давно удалённые разделы.

- Яндекс.Вебмастер: Логика похожая, но есть нюанс. Раздел «Индексирование» → «Страницы в поиске» → фильтр «С ошибкой 404» — это наш приоритет. Яндекс, по моим наблюдениям, часто «цепляет» больше технического мусора через старые внешние ссылки.

> Моё экспертное мнение: Не доверяйте слепо отчету «Исключено» в GSC как истине в последней инстанции. Там показаны только те страницы, которые робот *попытался* сканировать. Тысячи дублей или служебных страниц, на которые он не пошёл, в этом отчете не появятся. Это лишь верхний слой.

2. Операторы поиска: ручная разведка «на местности»

Отчеты — это хорошо, но иногда нужно проверить гипотезу вручную. Запоминайте два ключевых оператора:

- `site:yourdomain.com inurl:?` — главный оператор для охоты на дубли. Он покажет все проиндексированные страницы с параметрами (фильтры, сессии, UTM-метки). Если в выдаче тысячи результатов — у вас серьезная проблема с управлением параметрами.

- `site:yourdomain.com/важная-папка/ 404` — помогает найти упоминания битых страниц внутри конкретного раздела (например, после переезда блога).

Почему это важно? Потому что так вы видите проблему глазами пользователя, который ищет через Google или Яндекс. И если вы видите в выдаче `site.ru/product?color=red&size=XL` — это прямая дорога к настройке канонических тегов и обработки параметров в GSC.

3. SEO-краулеры (Screaming Frog, NetPeak Spider): полная инвентаризация сайта

Вебмастеры показывают то, что видят поисковики. Краулер покажет объективную реальность вашего сайта здесь и сейчас. Это наш «скальпель».

*Что конкретно делать:* Запустите сканирование всего сайта. После его завершения отфильтруйте:

- Код ответа 404 (прямо во вкладке Response Codes). Это все битые страницы, которые *есть на сайте* (висят ссылки).

- Дубликаты заголовков и мета-описаний — индикатор проблем с дублями контента.

- Страницы с метатегом noindex — чтобы убедиться, что вы случайно не закрыли от индексации нужное.

- Все URL с вопросами (`?`) в адресе — наш главный «параметрический» мусор.

Личный протокол: Я всегда сравниваю список URL с 404 из краулера со списком из GSC. Если в краулере 404 есть, а в GSC их нет — значит, на них нет внешних ссылок и робот их просто не нашёл. Это внутренняя проблема. Если 404 есть и там, и там — это сигнал о серьезных «входящих» ссылках.

4. Анализ логов сервера (Server Logs): абсолютная истина

Это самый сложный, но и самый честный источник. Логи показывают не то, что *может* видеть робот, а то, что он уже посетил в реальности.

*Что мы там ищем:*

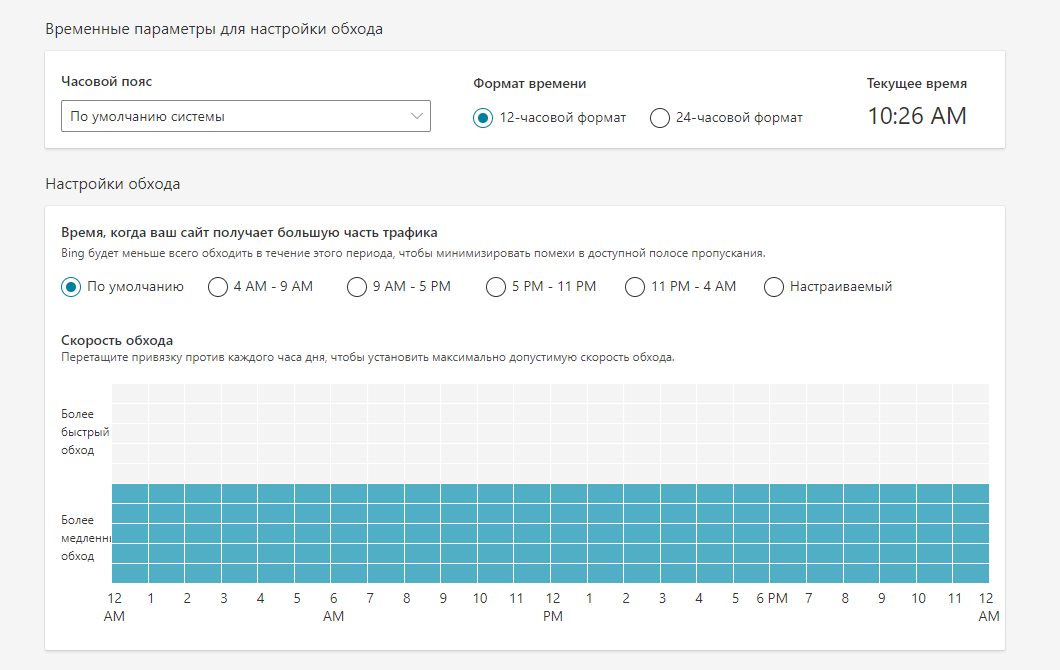

- Частоту визитов роботов Googlebot и YandexBot на явно мусорные страницы (фильтры, сессии). Если они там ползают каждый день — это прямое доказательство утечки бюджета.

- Цепочки редиректов. В логах видно, как робот с одного битого URL идет на другой, тратя время.

- Страницы, которые не видны краулерам (например, сгенерированные динамически только для поисковиков — опасная практика).

Практический вывод: Если у вас крупный сайт (от 10 тыс. страниц), лог-анализ — не опция, а необходимость. Без него вы действуете вслепую. Инструменты вроде Screaming Frog могут парсить логи и накладывать данные на карту сайта.

Итог диагностики: Соберите данные из всех четырёх источников в одну таблицу (например, в Google Sheets). Сравните. Пересечение данных из логов и вебмастеров — это ваш приоритетный список на чистку.

Глава 3: Инструкция по чистке: не просто удалить, а принять стратегическое решение

Самая большая ошибка на этом этапе — хвататься за инструмент удаления URL в Вебмастере, не разобравшись с судьбой каждой страницы. Это как заклеить скотчем трещину в фундаменте. Сначала — диагноз и стратегия, потом — техническое вмешательство.

Шаг 1: Решите судьбу страницы. Три пути и их долгосрочные последствия

Здесь нет универсального ответа. Есть три сценария, и выбор между ними определяет, получите вы пользу или новые проблемы.

- Страница удалена НАВСЕГДА. Ваш выбор: 404 или 410.

- Обычный 404 (Not Found) — стандартный ответ сервера «здесь ничего нет». Для поисковика это сигнал: «страницы нет, но мы не уверены, была ли она вообще или куда-то делась». URL может висеть в очереди на проверку ещё долго.

- Статус 410 (Gone) — это гораздо более сильный и профессиональный сигнал. Он говорит: «страница была, но намеренно удалена навсегда, и её больше не будет». Это прямое указание поисковым системам быстрее исключить URL из индекса.

- Контент ПЕРЕМЕЩЁН. Ваш выбор: 301 редирект (Moved Permanently).

- Главное правило: Редирект должен вести на максимально релевантную целевую страницу. Переехала статья про «уход за кактусами»? Вести нужно на новую статью про «уход за кактусами», а не просто на раздел «Блог».

- Частая ошибка: Создание длинных цепочек редиректов (страница А → B → C). Каждое дополнительное звено — потеря скорости и «размывание» ссылочного веса. По возможности, настраивайте прямой редирект со старого URL на новый конечный.

- Страница НЕ ДОЛЖНА ИНДЕКСИРОВАТЬСЯ (корзина, фильтры, поиск). Ваш выбор: комбинированная защита.

- `robots.txt` — директива `Disallow`. Это первый заслон. Мы *просим* роботов не заходить в служебные разделы (`Disallow: /cart/`, `Disallow: /search/`, `Disallow: /*?filter=`).

- Метатег `noindex` на самой странице. Это наш главный аргумент. Даже если робот игнорирует `robots.txt` и зайдет на страницу (а они это иногда делают), тег `noindex` даст четкую команду: «не добавляй эту страницу в поиск».

- Атрибут `rel="nofollow"` на ссылках, ведущих на такие страницы (например, кнопка «Корзина»). Это минимизирует передачу веса.

Моё предпочтение: Для страниц, которые вы сознательно и окончательно удалили (старые акции, неактуальные новости, снятые с производства товары), всегда настраивайте 410. Мы неоднократно замеряли: 410 удаляется из индекса Google и Яндекс заметно быстрее, чем 404. Это уважительный разговор с роботом на его языке.

Инсайт из практики: При массовом переезде (например, смена структуры `/blog/` на `/articles/`) используйте регулярные выражения в файле `.htaccess` (для Apache) или через конфиг сервера Nginx. Это в разы надежнее и быстрее, чем вбивать тысячи редиректов вручную через плагины, которые могут нагрузить базу данных.

Почему так строго? Потому что я видел, как в выдаче появлялись страницы корзин с товарами конкретных пользователей, потому что разработчик забыл про `noindex`. Это не только SEO-мусор, но и угроза безопасности.

Главный вывод этого шага: Прежде чем нажимать кнопки в панелях вебмастеров, вы должны для каждой проблемной страницы из вашего списка определить её судьбу: 410, 301 или noindex+disallow. Без этой карты действий дальнейшие шаги бессмысленны.

Шаг 2: Удаление страниц из поиска. Работа с панелями вебмастеров

Важное предупреждение: Инструменты удаления в GSC и Яндекс.Вебмастере — это не волшебная кнопка «стереть». Это запрос на перепроверку. Вы сообщаете поисковику: «Эй, посмотри сюда ещё раз, я тут кое-что поменял». А дальше он проверяет, выполнили ли вы условия.

Условия у Google и Яндекс разные, и это ключевой момент.

Процедура для Google Search Console

Google в этом плане более гибкий. У вас есть два основных сценария:

- Временное скрытие на 6 месяцев (Быстрое удаление).

- Что делает: Практически мгновенно (в течение суток) убирает URL из поиска Google. Не удаляет из индекса, а скрывает.

- Когда использовать: В случае ЧП. Вы обнаружили в индексе страницу с персональными данными, конфиденциальным коммерческим предложением или следы взлома. Вам нужно убрать её срочно.

- Важно: Это временная мера. У вас есть 6 месяцев, чтобы за это время технически исправить ситуацию (поставить `noindex`, `404` или пароль) и дать роботу переобойти страницу. Иначе через полгода она может вернуться в выдачу.

- Запрос на удаление из индекса (Постоянное удаление).

- Логика Google: Чтобы URL удалили навсегда, он должен соответствовать одному из условий:

- Отдавать код 404 или 410.

- Быть закрытой паролем.

- Иметь метатег `noindex` и быть доступной для краула (не заблокированной в `robots.txt`!).

- Как делать:

- Убедитесь, что страница технически соответствует одному из условий выше (например, отдаёт 410).

- В GSC идём в «Удаление URL» -> «Временное удаление» -> вводим URL -> выбираем опцию «Удалить только этот URL» или «Удалить URL и его копии» (если это дубль).

- Отправляем запрос. Через 1-3 дня робот перепроверит страницу и, увидев 410/404/noindex, удалит её из индекса.

Моё мнение: Не злоупотребляйте временным удалением для решения технических проблем. Если у вас тысяча битых страниц, это не метод. Поставьте им 410, а затем используйте инструмент «Проверить URL» для каждого, чтобы ускорить переобход. Или просто ждите — Google сам со временем их вычистит, если они действительно не работают.

Процедура для Яндекс.Вебмастера

Яндекс более строгий и формальный. Его принцип: «Сначала ты технически запрети, потом мы удалим».

- Жёсткое условие: Перед запросом на удаление страница обязательно должна быть закрыта от индексации одним из двух способов:

- Метатегом ``.

- Директивой `Disallow` в файле `robots.txt`.

- Алгоритм действий (строго по порядку!):

- Шаг А: Технически закрываем страницу (ставим `noindex` или добавляем в `Disallow`).

- Шаг Б: В Яндекс.Вебмастере идём в «Индексирование» -> «Удалить URL». Вставляем адрес.

- Шаг В: Ждём, когда робот Яндекс переобойдёт страницу и увидит запрет. Это может занять от нескольких дней до недель. Только после этого он выполнит удаление.

- Ускорение процесса: Можно отправить URL на переобход через инструмент «Переобход страниц», но это не гарантия мгновенного результата.

Ключевое отличие от Google: Яндекс не удалит страницу, которая отдаёт просто 404 или 410. Её нужно сначала явно запретить через `noindex` или `robots.txt`. Это часто упускают, а потом удивляются, почему запрос на удаление «висит».

Практический совет:

После всех манипуляций создайте таблицу контроля:

| URL | Проблема | Принятая мера (410/301/noindex) | Запрос в GSC | Статус в GSC | Запрос в ЯВ | Статус в ЯВ |

|---|---|---|---|---|---|---|

| <Описание проблемы> | <Применённое решение> | <Результат запроса в GSC> | <Статус обработки в GSC> | <Результат запроса в ЯВ> | <Статус обработки в ЯВ> |

Отмечайте статусы. Это избавит от хаоса, особенно при работе с большими объёмами.

Шаг 3: Устранение причин. Строим систему, а не латаем дыры

Здесь многие останавливаются. Удалили страницы, вздохнули с облегчением — и через полгода получили ту же проблему в удвоенном объёме. Потому что не добрались до корня. Наша задача — внедрить превентивные настройки, которые сведут появление нового «мусора» к минимуму.

1. Настройка `robots.txt`: Ваш закон для роботов

Не воспринимайте этот файл как формальность. Это юридический документ, регламентирующий, что можно, а что нельзя на вашей территории.

- Обязательные запреты (Disallow):

- Служебные разделы: `Disallow: /cart/`, `Disallow: /checkout/`, `Disallow: /my-account/`, `Disallow: /admin/` (если он доступен по прямому URL).

- Внутренний поиск: `Disallow: /search/`. Это правило №1.

- Параметры сессий, фильтров, сортировки: Если вы не можете настроить корректную обработку параметров в GSC/ЯВ, запрещайте их глобально. Например: `Disallow: /*?*sort=`, `Disallow: /*?*filter_`.

- Системные файлы: `Disallow: /bitrix/`, `Disallow: /wp-admin/`, `Disallow: /includes/`.

- Важное уточнение: Запрет в `robots.txt` не позволяет индексировать страницу, но если на неё есть сильные внешние ссылки, робот может её проигнорировать и просканировать. Поэтому `Disallow` — это первый, но не единственный рубеж.

2. Пропишите канонические теги (`rel="canonical`): Дирижёр для дублей

Это ваш главный инструмент в борьбе с дублированием контента. Канонический тег — это явное указание поисковику: «Вот эта версия страницы — главная. Все остальные варианты её URL — просто её отражения, не обращай на них внимания».

Где его ставить обязательно:

- На все страницы с параметрами (`?utm_source=...`, `?ref=...`). Канонической должна быть чистая версия без параметров.

- На HTTP-версии, если у вас работает HTTPS (каноническая — HTTPS).

- На версии с `www` (или без `www`) — в зависимости от выбранного основного зеркала.

- На страницы пагинации (`/blog/page/2/`). Их каноническая версия — это первая страница раздела (`/blog/`) или сама статья, если это разбивка длинного текста.

Профессиональный лайфхак: Для динамических страниц (фильтры, сортировки) иногда эффективнее использовать не `rel="canonical"`, а метатег `noindex, follow`. Потому что страница с фильтром «красные кроссовки до 5000 руб» — по сути, уникальная подборка, и канонизировать её на общий каталог «все кроссовки» не всегда логично. Лучше просто запретить её индексацию, но позволить сканировать ссылки.

3. Очистка и оптимизация `sitemap.xml`

Карта сайта — это ваш официальный invite-лист для робота. Следите, чтобы в него не попадали случайные гости.

Что проверять:

- В карте не должно быть URL, которые отдают 404/410 или закрыты `noindex`.

- В карте не должно быть служебных страниц, фильтров, сессий.

- Приоритет (`priority`) и частота обновления (`changefreq`) — не критичны, но лучше выставить адекватно.

Как автоматизировать: Используйте плагины или скрипты, которые динамически генерируют карту сайта на основе актуальных данных, а не статический файл, который вы забываете обновлять.

4. Исправление внутренних ссылок: Лечение болезни, а не симптома

Битые ссылки на самом сайте — это признак плохой поддержки. Они портят пользовательский опыт и вводят в заблуждение роботов.

Инструменты: Используйте краулеры (Screaming Frog), плагины для CMS (например, Broken Link Checker для WordPress) или скрипты для регулярной проверки.

Процедура: Получив список битых внутренних ссылок, для каждой примите решение:

- Восстановить корректную страницу? → Создать её.

- Страница перемещена? → Настроить 301 редирект.

- Страница удалена навсегда? → Убрать ссылку или заменить её ссылкой на релевантный другой материал.

Заключение: Контроль индекса — базовая обязанность, а не героизм

Проведённая работа — не «оптимизация», а приведение сайта в базовое техническое соответствие. Наличие битых и служебных страниц в поиске — это не угроза, это доказательство недосмотра. Устранив их, вы не получите бонусов, а просто прекратите наносить системный ущерб ранжированию.

Ключевые выводы:

- Краулинговый бюджет — материальный актив. Его утечка на мусорные страницы напрямую тормозит индексацию нового контента и снижает скорость реагирования поиска на изменения. Чистка — это его защита.

- Дубли и 404 — это шум. Поисковые алгоритмы работают с сигналами. Масса нерелевантных URL создаёт информационный шум, который размывает вес и релевантность ключевых разделов. Убрав шум, вы усилили основной сигнал.

- Без системы проблема вернётся. Разовые действия бесполезны. Ценность представляет внедрённый процесс: регулярный аудит через GSC/ЯВ и краулеры, автоматизированная обработка 404 через 410, жёсткие правила в `robots.txt` и для канонических тегов.

- Инструменты — не гарантия. Яндекс.Вебмастер и Google Search Console — это интерфейсы для диагностики и подачи запросов. Решение лежит на уровне сервера (коды ответов, редиректы) и разметки (`noindex`, `canonical`). Не путайте запрос на удаление с самим удалением.

Итог: Чистка поисковой выдачи — не кампания по «улучшению SEO». Это непрерывная техническая гигиена, такая же обязательная, как обновление CMS или резервное копирование. Её результат — не рост позиций «с завтрашнего дня», а точное, предсказуемое и эффективное взаимодействие вашего сайта с поисковыми системами. Вы прекращаете саботировать сами себя.

|

Откройте любой проект в Google Search Console, который не проходил регулярный техаудит. В 9 из 10 случаев в разделе «Индексирование» → «Страницы» вы найдете сотни, а иногда и тысячи исключённых URL. Большинство — это 404, страницы с редиректами или заблокированные ресурсы. |

Введение: Ненужные страницы в индексе — это тихий слив бюджета и позиций |

|

Откройте любой проект в Google Search Console, который не проходил регулярный техаудит. В 9 из 10 случаев в разделе «Индексирование» → «Страницы» вы найдете сотни, а иногда и тысячи исключённых URL. Большинство — это 404, страницы с редиректами или заблокированные ресурсы. |

Введение: Ненужные страницы в индексе — это тихий слив бюджета и позиций |

Дайджест новых статей по интернет-маркетингу на ваш email

Новые статьи и публикации

- 2026-01-23 » Ключ к эффективному управлению бизнесом: что такое ERP-системы и как они помогают компании

- 2025-12-23 » API Яндекс Бизнеса: как подключить карточки компании к вашей CRM или ERP-системе

- 2025-12-23 » Как управлять всеми филиалами в Яндекс Картах из одной панели

- 2025-12-23 » От отзыва к продаже: система быстрого ответа и управления репутацией через интеграцию

- 2025-12-23 » Оформление карточки организации в Яндекс Бизнес = Продающее оформление вашей компании на Яндекс Картах

- 2025-12-23 » Из чего складывается стоимость логотипа: разбираем по полочкам

- 2025-12-23 » Как провести ребрендинг логотипа, не потеряв старых клиентов

- 2025-12-23 » Логотип vs. Иконка: Что на самом деле нужно вашему бизнесу?

- 2025-12-23 » Трейд-маркетинг: как продвигать товары в точках продаж

- 2025-12-23 » Подписная модель: стратегия, риски и эффективность

- 2025-12-23 » Чёрный список почтовых серверов: как защитить рассылки от блокировки

- 2025-12-23 » Закон о рекомендательных технологиях: как использовать их легально

- 2025-12-23 » Как управлять жизненным циклом продукта: от запуска до спада

- 2025-12-17 » Почему медленный госсайт — это провал и как это исправить

- 2025-12-17 » Как соответствовать требованиям 152-ФЗ и 210-ФЗ при разработке государственных сайтов

- 2025-12-17 » Интеграция госсайта с внешними системами: от визитки к цифровому сервису

- 2025-12-17 » Введение: Ненужные страницы в индексе — это тихий слив бюджета и позиций

- 2025-12-17 » Продвинутая работа с анкорным профилем: баланс, многоуровневая стратегия и защита от спама

- 2025-12-17 » >Как удержать и повысить продажи после праздников

- 2025-12-17 » Почему сегодня офлайн-данные и SEO — это единая система

- 2025-12-17 » Надёжная доставка кодов входа: каскадная логика, которая защищает конверсию

- 2025-12-11 » Будущее SEO в эпоху ИИ: тренды 2024-2025 и стратегии адаптации

- 2025-12-11 » Техническое SEO 2025: Фундаментальное руководство по созданию безупречного цифрового актива

- 2025-12-11 » 10 устаревших SEO-ошибок, которые мешают росту в 2026 году + чек-лист для срочной проверки сайта

- 2025-12-11 » Навигация типа «хлебные крошки»: современный подход к удобству сайта

- 2025-12-11 » Оптимизация сайтов: как микроразметка Schema.org влияет на видимость и привлечение клиентов

- 2025-12-11 » Вирусы на сайте: как обнаружить, обезвредить и предотвратить угрозу

- 2025-12-11 » Generative Engine Optimization (GEO): как работать с новым типом поиска

- 2025-12-02 » Когда ошибка молчит: как бессмысленные сообщения ломают пользовательский опыт

- 2025-12-02 » 9 лучших бесплатных фотостоков

Большинство людей, стремящихся к цели, способны скорее сделать одно большое усилие, чем упорно идти избранной дорогой; из-за лени и непостоянства они часто утрачивают плоды лучших своих начинаний и дают обогнать себя тем, кто отправился в путь позднее, чем они, и шел медленней, но зато безостановочно Лабрюйер Жан де (1645-1696) - французский писатель, мастер афористической публицистики |

Мы создаем сайты, которые работают! Профессионально обслуживаем и продвигаем их !

Как мы работаем

Заявка

Позвоните или оставьте заявку на сайте.

Консультация

Обсуждаем что именно Вам нужно и помогаем определить как это лучше сделать!

Договор

Заключаем договор на оказание услуг, в котором прописаны условия и обязанности обеих сторон.

Выполнение работ

Непосредственно оказание требующихся услуг и работ по вашему заданию.

Поддержка

Сдача выполненых работ, последующие корректировки и поддержка при необходимости.

Мы создаем практически любые сайты от продающих страниц до сложных, высоконагруженных и нестандартных веб приложений! Наши сайты это надежные маркетинговые инструменты для успеха Вашего бизнеса и увеличения вашей прибыли! Мы делаем красивые и максимально эффектные сайты по доступным ценам уже много лет!

Мы создаем практически любые сайты от продающих страниц до сложных, высоконагруженных и нестандартных веб приложений! Наши сайты это надежные маркетинговые инструменты для успеха Вашего бизнеса и увеличения вашей прибыли! Мы делаем красивые и максимально эффектные сайты по доступным ценам уже много лет! Комплексный подход это не просто продвижение сайта, это целый комплекс мероприятий, который определяется целями и задачами поставленными перед сайтом и организацией, которая за этим стоит. Время однобоких методов в продвижении сайтов уже прошло, конкуренция слишком высока, чтобы была возможность расслабиться и получать \ удерживать клиентов из Интернета, просто сделав сайт и не занимаясь им...

Комплексный подход это не просто продвижение сайта, это целый комплекс мероприятий, который определяется целями и задачами поставленными перед сайтом и организацией, которая за этим стоит. Время однобоких методов в продвижении сайтов уже прошло, конкуренция слишком высока, чтобы была возможность расслабиться и получать \ удерживать клиентов из Интернета, просто сделав сайт и не занимаясь им...

Мы оказываем полный комплекс услуг по сопровождению сайта: информационному и техническому обслуживанию и развитию Интернет сайтов.

Мы оказываем полный комплекс услуг по сопровождению сайта: информационному и техническому обслуживанию и развитию Интернет сайтов.

Контекстная реклама - это эффективный инструмент в интернет маркетинге, целью которого является увеличение продаж. Главный плюс контекстной рекламы заключается в том, что она работает избирательно.

Контекстная реклама - это эффективный инструмент в интернет маркетинге, целью которого является увеличение продаж. Главный плюс контекстной рекламы заключается в том, что она работает избирательно.